# Les plateformes de “Cloud Computing” académiques françaises

:::danger

*Page encours de rédaction et de révision. Rafraîchissez souvent la page avant toute lecture! Merci d'avance de votre contribution pour toute modification.*

:::

:::info

Toutes les ressources de calcul cloud et les services mis à disposition sur ces plateformes sont ouvertes à la communauté académique et recherche française (ESR). N'hésitez donc pas à prendre contact directement avec ces structures généralement dédiées pour détailler vos besoins spécifiquement.

:::

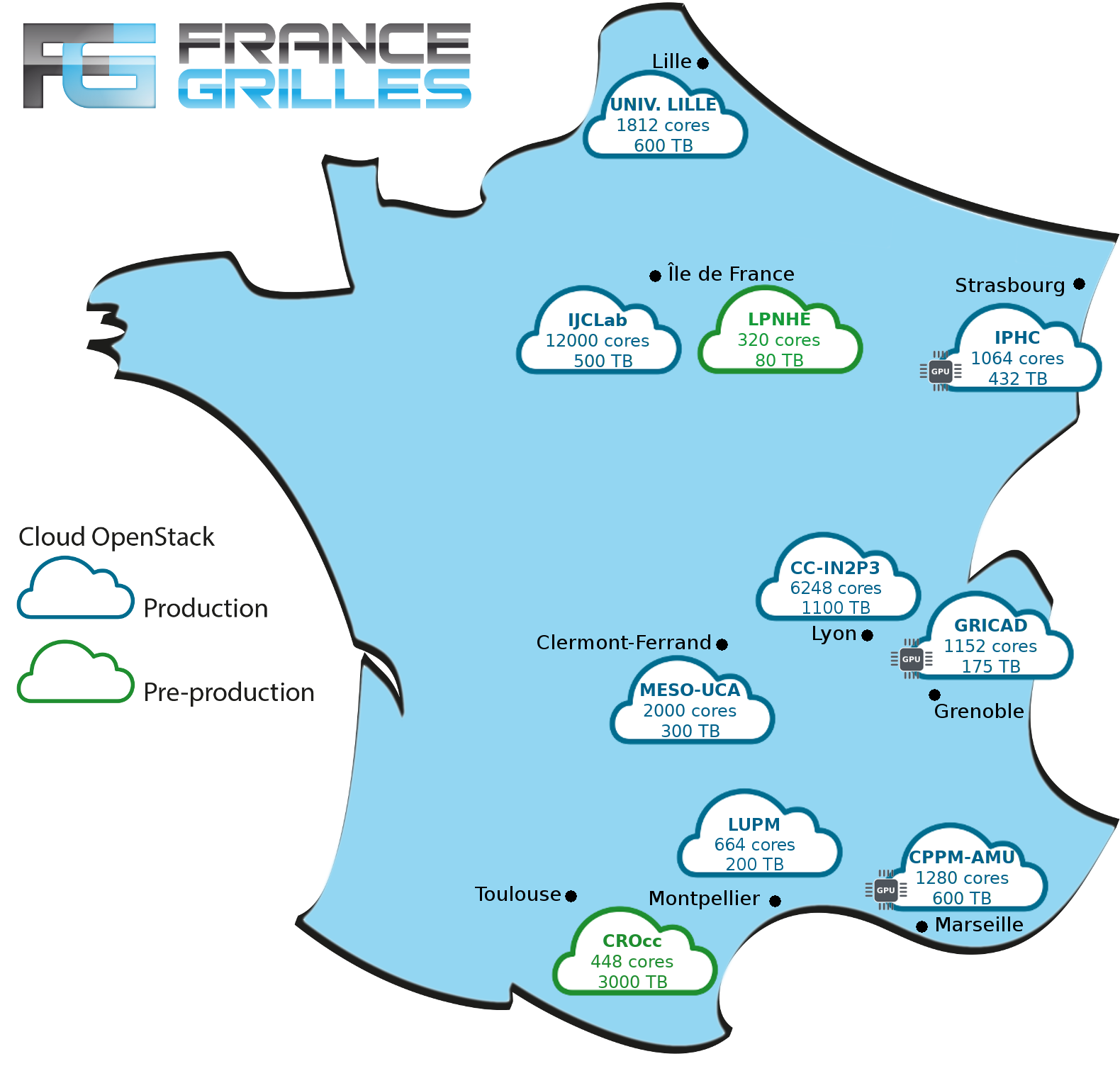

[*Source France-Grilles*](https://www.france-grilles.fr/tag/ressources-cloud/)

Dans le cadre de

## Auvergne-Rhône-Alpes

### Cloud Computing NOVA @ GRICAD (Grenoble)

<style>

.gricad {

width: 70%;

text-align: center;

}

.gricad tr:nth-child(1) { background: lightgreen; }

</style><div class="gricad">

| Accès ouvert et gratuit pour l'ESR |

| ---------------------------------- |

</div>

>[Hébergé par GRICAD, Scientific Computing and Data Infrastructure de Grenoble](https://gricad-doc.univ-grenoble-alpes.fr/nova)

* [Contact](https://gricad-doc.univ-grenoble-alpes.fr/support)

* Accessible via [France Grilles](http://www.france-grilles.fr/home)

* Technologies : *OpenStack et CEPH*

* [Ressources](https://gricad-doc.univ-grenoble-alpes.fr/nova/cloud_resources/) :

```

~1152 cœurs physiques,

519 To de stockage,

GPUs

```

### Plateforme OSCAR @ Mésocentre UCA (Clermont)

<style>

.oscar {

width: 70%;

text-align: center;

}

.oscar tr:nth-child(1) { background: orange; }

</style><div class="oscar">

| Politique d'accès en cours... |

| ----------------------------- |

</div>

* [Hébergé par l'Université de Clermont-Auvergne](https://mesocentre.uca.fr/ressources)

* Projet co-initié par le laboratoire LPC de Clermont

* Accessible soit via [France Grilles](http://www.france-grilles.fr/home) et [IFB](https://www.france-bioinformatique.fr)

* Technologies : *OpenStack et CEPH*

* [Ressources](https://mesocentre.uca.fr/ressources/acces-aux-ressources) :

```

~2000 cœurs physiques,

300 To de stockage

```

### Cloud IaaS @ CC-IN2P3 (Lyon)

<style>

.lupm {

width: 70%;

text-align: center;

}

.lupm tr:nth-child(1) { background: lightgreen; }

</style><div class="lupm">

| Accès ouvert, mais orienté labo/exp/institut CNRS |

| ------------------------------------------------- |

</div>

>Tout laboratoire ou expérience de l’IN2P3 disposant d’un compte au CC-IN2P3, est éligible à l’utilisation du cloud. D’une manière générale, tout laboratoire, expérience ou institut du CNRS, ainsi que des autres organes de la recherche académique nationale et internationale peuvent faire une demande d’accès au service.

* Contact [support user](https://support.cc.in2p3.fr/#login)

* Technologies : *OpenStack et CEPH (en cours de bascule)*

* [Documentation](https://doc.cc.in2p3.fr/fr/Hosting/cloud-iaas.html)

* Ressources :

```

~6200 cpus

1100 TB de stockage

```

----

<!--## Bourgogne-Franche-Comté

## Bretagne

## Centre-Val de France

## Corse

-->

## Grand-Est

### Plateforme SCIGNE @ IPHC (Strasbourg)

<style>

.scigne {

width: 70%;

text-align: center;

}

.scigne tr:nth-child(1) { background: lightgreen; }

</style><div class="scigne">

| Accès ouvert et gratuit pour l'ESR |

| ----------------------------- |

</div>

[Hébergée et gérée par l’IPHC (Strasbourg)](https://grand-est.fr)

* Projet co-initié par le mésocentre de l'Université de Strasbourg

* [Contact](https://scigne.fr/en/about-us/contact-us/)

* Accessible soit via [France Grilles](http://www.france-grilles.fr/home), [IFB](https://www.france-bioinformatique.fr) et [EGI](https://www.egi.eu/infrastructure/cloud)

* Technologies : *OpenStack et CEPH*

* Services : *Kubernetes-as-a-service, scientific computation, etc.*

* Ressources :

```

~1064 cœurs physiques,

432 To de stockage,

GPUs

```

----

## Hauts-de-France

### IAAS @ Mésocentre de Lille

<style>

.iaaslille {

width: 70%;

text-align: center;

}

.iaaslille tr:nth-child(1) { background: lightgreen; }

</style><div class="iaaslille">

| Accès ouvert et gratuit pour l'ESR |

| ---------------------------------- |

</div>

* [Hébergé par le mésocentre de l'Université de Lille](http://hpc.univ-lille.fr/cloud-openstack)

* [Contact](http://hpc.univ-lille.fr/contact)

* Accessible soit via [France Grilles](http://www.france-grilles.fr/home), [IFB](https://www.france-bioinformatique.fr) et [EGI](https://www.egi.eu/infrastructure/cloud)

* Technologies: *OpenStack et CEPH*

* Ressources:

```

1812 cœurs physiques,

21,6 To de mémoire vive et

600 To de stockage

```

----

## Ile-de-France

### Cloud Computing @ LPNHE (Paris)

<style>

.lpnhe {

width: 70%;

text-align: center;

}

.lpnhe tr:nth-child(1) { background: orange; }

</style><div class="lpnhe">

| Pré-production |

| -------------- |

</div>

>Hébergé par le [LPNHE](https://lpnhe.in2p3.fr/spip.php?rubrique480)

* Technologies : *OpenStack et CEPH*

* Ressources

```

320 cœurs virtuels sur 5 noeuds physiques,

1 To RAM,

80 TB de stockage

```

### VirtualData @ IJCLAB (Orsay)

<style>

.ijc {

width: 70%;

text-align: center;

}

.ijc tr:nth-child(1) { background: yellow; }

</style><div class="ijc">

| Accès limité et sur demande |

| --------------------------- |

</div>

>Hébergé par le [P2IO](https://openstack.lal.in2p3.fr/) à Orsay, [IJCLab](https://www.ijclab.in2p3.fr)

* Contact: vd-cloud-admin-l@in2p3.fr

* [Informations complémentaires](https://cat.opidor.fr/index.php/VirtualData)

* Accessible via [France Grilles](http://www.france-grilles.fr/home)

* Technologies : *OpenStack et CEPH*

* Ressources :

```

~12000 cœurs physiques,

500 To de stockage

```

* Services pour la recherche :

- VM à la demande et "jetable", service [Lease-IT](https://openstack.ijclab.in2p3.fr/2017/10/10/nouveau-service-openstack-lease-it/)

- Spark (300 cores / 40 TB),

- JupyterHub (80 cores),

- DW4NP (Data Workflow 4 Nuclear Physics - projet CSNSM-IPNO),

- Kubernetes-as-a-service

### IFB Cloud Plateforme (Paris)

<style>

.ifb {

width: 70%;

text-align: center;

}

.ifb tr:nth-child(1) { background: lightgreen; }

</style><div class="ifb">

| Accès ouvert et gratuit pour l'ESR pour la bioinfo |

| -------------------------------------------------- |

</div>

> La plateforme offre, à la demande, des ressources informatiques et des données de référence où les utilisateurs pourront soit déployer des appliances (machines préconfigurées), soit installer leur propre infrastructure bioinformatique. Selon la configuration, les machines déployées ou installées sont accessibles de différentes manières : interface web, ligne de commande et bureau graphique.

- https://www.france-bioinformatique.fr/en/ifb-cloud

- [Carte des plateformes partenaires](https://www.france-bioinformatique.fr/plateformes/)

- Technologies: *OpenStack* via l'outil [RainBio](https://biosphere.france-bioinformatique.fr/catalogue)

<!--

## Normandie

## Nouvelle Aquitaine

-->

### Services par PLM/Mathrice (Paris)

<style>

.plm {

width: 70%;

text-align: center;

}

.plm tr:nth-child(1) { background: yellow; }

</style><div class="plm">

| Accès ouvert et gratuit pour la communauté mathématique et limité pour ses partenaires |

| -------------------------------------------------------------------------------------- |

</div>

- Contact: support@math.cnrs.fr

#### JupyterCloud (en collaboration avec le Groupe Calcul)

>*C'est la nouvelle offre de services de NoteBooks Jupyter et d'instance JupyterHub à la demande, pour la communauté mathématique et ses partenaires. Accédez en ligne à vos notebooks, exécutez-les, partagez-les, connectez-les à des espaces de données (par exemple pour l'IA, le machine learning)*

- Portail: https://jupytercloud.math.cnrs.fr

- Technologies: *JupyterLab et OpenSHIFT*

- Pour la communauté ESR, un [portail hub dédié](https://plmdatahub.math.cnrs.fr/hub)

- par notebook :

```

RAM: 2 Go

Disque temporaire: 2 Go

vGPU: 2 max.

```

- Plateforme PlmDataHub :

```

100 CPUs

256 Go RAM

10 vGPUs

```

#### PLMShift de Mathrice

>*Déploiement simplifié d'applications web*

- [Portail](https://plmshift.math.cnrs.fr)

- Technologies: *OpenSHIFT*

----

## Occitanie

### DROcc (Cloud Recherche du Datacenter Régional Occitan) - Montpellier

<style>

.crocc {

width: 70%;

text-align: center;

}

.crocc tr:nth-child(1) { background: orange; }

</style><div class="crocc">

| Pré-production |

| -------------- |

</div>

> ...

* [Contact](https://groupes.renater.fr/sympa/info/drocc-crocc-contact)

* Site web: https://drocc.fr

* Hébergé actuellement dans le mésocentre meso@LR au CINES

* Accessible via [France Grilles](http://www.france-grilles.fr/home)

* Technologies : *OpenStack et CEPH*

* Ressources :

```

448 cœurs physiques,

3000 To de stockage

```

### LUPM (Montpellier)

<style>

.lupm {

width: 70%;

text-align: center;

}

.lupm tr:nth-child(1) { background: lightgreen; }

</style><div class="lupm">

| Accès ouvert |

| ------------ |

</div>

> ...

* Contact

* Accessible via [France Grilles](http://www.france-grilles.fr/home)

* Technologies : *OpenStack et CEPH*

* Ressources :

```

664 cœurs physiques,

200 To de stockage

```

----

## Pays de la Loire

### GLICID (Nantes)

<style>

.ijclab {

width: 70%;

text-align: center;

}

.ijclab tr:nth-child(1) { background: orange; }

</style><div class="ijclab">

| Service en cours de déploiement |

| ------------------------------- |

</div>

>Une structure transversale au service des personnels des équipes et unités de recherche de la Région des Pays de la Loire, et de leurs partenaires académiques et/ou industriels.

- https://glicid.fr

- Contact contact@glicid.fr

----

## Provence Alpes Côte-d'Azur

### Cloud Computing @ Mésocentre AMU (Marseille)

<style>

.cloudamu {

width: 70%;

text-align: center;

}

.cloudamu tr:nth-child(1) { background: lightgreen; }

</style><div class="cloudamu">

| Accès ouvert et gratuit mais sur demande |

| ----------------------------- |

</div>

* [Hébergé par Université d'Aix Marseille](https://mesocentre.univ-amu.fr/ressources-cloud)

* [Contact](https://mesocentre.univ-amu.fr/coordonnees/)

* mesocentre-techn@univ-amu.fr ou

* directement [Carlos Carranza](carranza@cppm.in2p3.fr) sur l'aspect cloud.

* Accessible via [France Grilles](http://www.france-grilles.fr/home) et par un [dépôt de projet](https://mesocentre.univ-amu.fr/appel-a-projets/) (type C)

* Technologies: *OpenStack et CEPH*

* [Ressources](https://mesocentre.univ-amu.fr/ressources-cloud)

```

1536 cœurs physiques,

400To de stockage et 2Po en semi-permanent,

GPUs

```

----

### Cartographie de FranceGrilles sur les infra cloud

*Update octobre 2022*

[](https://www.france-grilles.fr/tag/ressources-cloud/)

- [Cloud Status](https://cloud-status.fedcloud.fr/)